Baseline-modellen zijn enorme deep learning-modellen die vooraf zijn getraind op een enorme hoeveelheid openbare, ongelabelde gegevens. Het kan worden toegepast op een verscheidenheid aan taken, zoals het maken van afbeeldingen of het beantwoorden van vragen van klanten.

Maar deze modellen, die de ruggengraat vormen van krachtige AI-tools zoals ChatGPT en DALL-E, kunnen onjuiste of misleidende informatie opleveren. In een veiligheidskritische situatie, zoals een voetganger die een zelfrijdende auto nadert, kunnen deze fouten ernstige gevolgen hebben.

Om dergelijke fouten te helpen voorkomen, hebben onderzoekers van MIT en het MIT-IBM Watson AI Laboratory Ontwikkel een techniek Om de betrouwbaarheid van basismodellen te schatten voordat ze voor een specifieke taak worden ingezet.

Dit doen ze door een set basismodellen te trainen die enigszins van elkaar verschillen. Vervolgens gebruiken ze hun algoritme om de consistentie te evalueren van de representaties die elk model leert over hetzelfde testgegevenspunt. Als de representaties consistent zijn, is het model betrouwbaar.

Toen ze hun techniek vergeleken met de modernste basislijnmethoden, was deze beter in het vastleggen van de betrouwbaarheid van basislijnmodellen voor een verscheidenheid aan classificatietaken.

Iedereen kan deze techniek gebruiken om te bepalen of een model in een bepaalde omgeving moet worden toegepast, zonder het op een echte dataset te hoeven testen. Dit kan met name handig zijn wanneer datasets niet beschikbaar zijn vanwege privacyoverwegingen, zoals in gezondheidszorgomgevingen. Bovendien kan deze techniek worden gebruikt om modellen te rangschikken op basis van betrouwbaarheidsscores, zodat de gebruiker het beste model voor zijn of haar taak kan kiezen.

“Alle modellen kunnen fout zijn, maar modellen die weten wanneer ze fout zijn, zijn “Het probleem van het bepalen van onzekerheid of betrouwbaarheid wordt voor deze basismodellen moeilijker omdat hun abstracte representaties moeilijk te vergelijken zijn. Met onze methode kun je de betrouwbaarheid van de modellen meten.” representatie voor bepaalde invoergegevens.”

ik heb mij aangesloten bij Werkpapier Geschreven door hoofdauteur Young-Jin Park, een afgestudeerde student aan MIT en het IBM AI Institute; Hao Wang, onderzoeker bij MIT's Watson AI Laboratory en IBM; en Shervin Ardashir, een senior wetenschappelijk onderzoeker bij Netflix. Het onderzoekspaper zal worden gepresenteerd op de conferentie Uncertainty in Artificial Intelligence.

Bereken consensus

Traditionele machine learning-modellen zijn getraind om een specifieke taak uit te voeren. Deze modellen maken meestal een concrete voorspelling op basis van input. Een model kan u bijvoorbeeld vertellen of een bepaalde afbeelding een kat of een hond bevat. In dit geval kan het beoordelen van de betrouwbaarheid slechts een kwestie zijn van kijken naar de uiteindelijke voorspelling om te zien of het model correct is.

Maar de funderingsmodellen zijn anders. Het model is vooraf getraind met behulp van openbare gegevens, in een omgeving waarin de makers ervan niet alle volgende taken kennen waarop het zal worden toegepast. Gebruikers passen het aan hun specifieke taken aan nadat ze het al hebben getraind.

In tegenstelling tot traditionele machine learning-modellen leveren basismodellen geen tastbare resultaten op, zoals ‘kat’- of ‘hond’-labels. In plaats daarvan genereren ze een abstracte weergave op basis van een invoergegevenspunt.

Om de betrouwbaarheid van het basismodel te evalueren, gebruikten onderzoekers een clusterbenadering door verschillende modellen te trainen die veel kenmerken gemeen hebben maar enigszins van elkaar verschillen.

“Ons idee lijkt op een consensusberekening”, zegt Park. “Als al deze basismodellen consistente weergaven bieden van alle gegevens in onze dataset, kunnen we zeggen dat dit model betrouwbaar is.”

Maar ze stonden voor een probleem: hoe konden ze abstracte representaties met elkaar vergelijken?

“Deze modellen produceren slechts een vector die uit een aantal getallen bestaat, dus we kunnen ze niet gemakkelijk vergelijken”, voegt hij eraan toe.

Ze hebben dit probleem opgelost met behulp van een idee genaamd live consistentie.

Volgens hun aanpak bereiden onderzoekers een reeks betrouwbare referentiepunten voor om op een reeks modellen te testen. Vervolgens onderzoeken ze voor elk model referentiepunten die zich in de buurt van de representatie van het testpunt door het model bevinden.

Door naar de consistentie van aangrenzende punten te kijken, kunnen ze de betrouwbaarheid van de modellen inschatten.

Voorstellingen uitlijnen

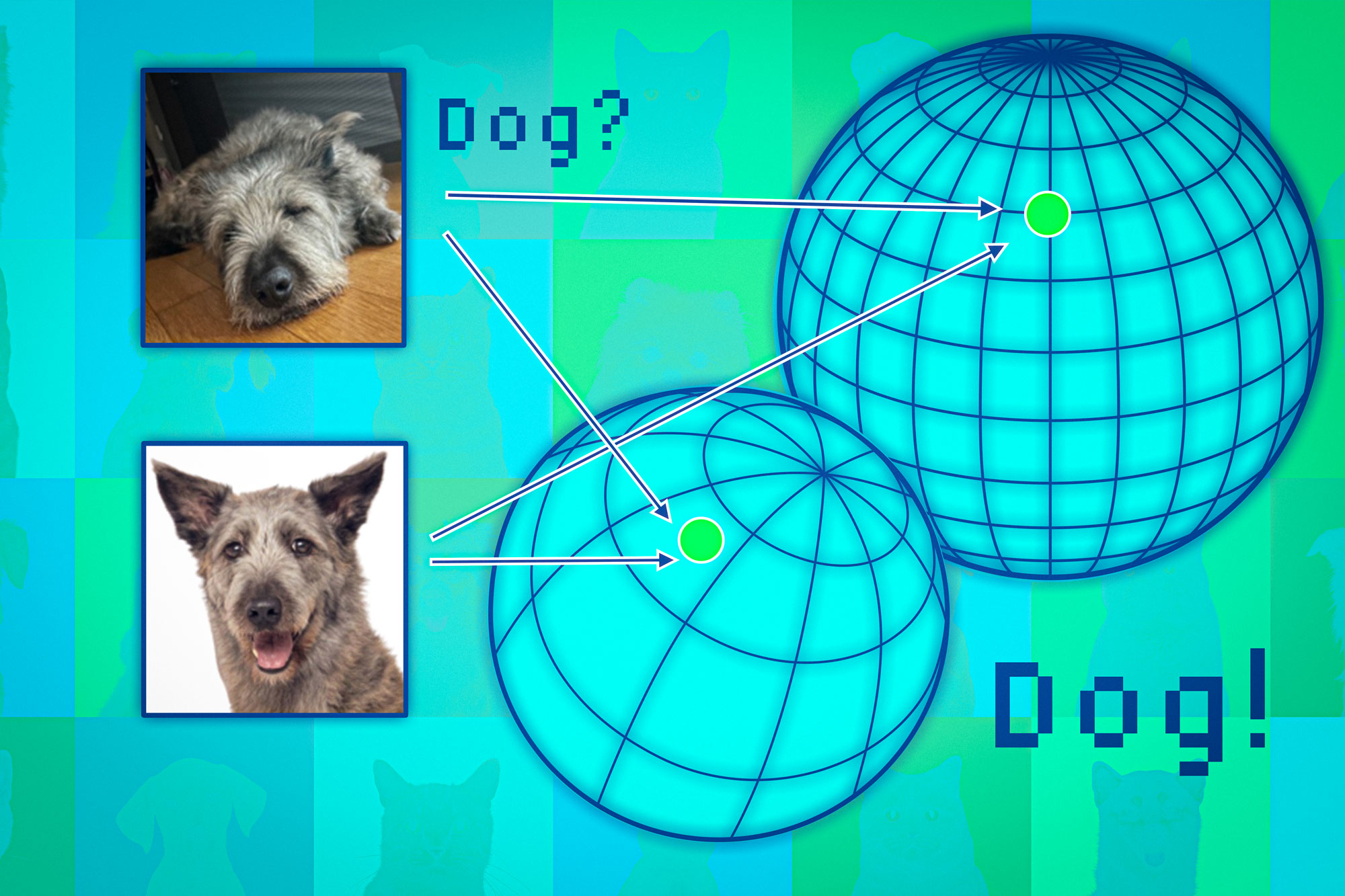

Basismodellen zetten datapunten uit in een zogenaamde representatieruimte. Eén manier om deze ruimte te beschouwen is als een bol. Elk model tekent identieke gegevenspunten uit voor hetzelfde deel van de bal, zodat afbeeldingen van katten op de ene plek verschijnen en afbeeldingen van honden op een andere plek.

Maar elk model zal dieren in zijn eigen domein op een andere manier in kaart brengen, dus terwijl katten voor één domein in de buurt van de Zuidpool kunnen worden gegroepeerd, kan een ander model katten ergens op het noordelijk halfrond in kaart brengen.

Onderzoekers gebruiken aangrenzende punten als ankers om deze gebieden op één lijn te brengen, zodat ze de representaties vergelijkbaar kunnen maken. Als de buren van een datapunt consistent zijn over meerdere representaties heen, moet men vertrouwen hebben in de betrouwbaarheid van de modeluitvoer voor dat punt.

Toen ze deze aanpak testten op een breed scala aan classificatietaken, ontdekten ze dat deze consistenter was dan de basislijnen. Bovendien werd de aanpak niet verzand door lastige testpunten waardoor andere methoden faalden.

Bovendien kan hun aanpak worden gebruikt om de betrouwbaarheid van invoergegevens te evalueren, en zo kan men evalueren hoe goed het model werkt met een bepaald type individu, zoals een patiënt met bepaalde kenmerken.

“Zelfs als alle modellen over het algemeen gemiddeld presteren, zou je vanuit individueel oogpunt de voorkeur geven aan het model dat het beste werkt voor dat individu”, zegt Wang.

Eén beperking komt echter voort uit het feit dat ze een reeks grote basismodellen moeten trainen, wat rekentechnisch duur is. In de toekomst zijn ze van plan efficiëntere manieren te vinden om meerdere modellen te bouwen, misschien met behulp van kleine verstoringen van één enkel model.

Dit werk werd gedeeltelijk gefinancierd door het MIT-IBM Watson AI Laboratory, MathWorks en Amazon.

“Reizende ninja. Onruststoker. Spekonderzoeker. Expert in extreme alcohol. Verdediger van zombies.”

More Stories

China is van plan het Tiangong-ruimtestation uit te breiden; Stel deze in op “Space Rule” omdat het ISS wordt uitgeschakeld

De Verenigde Staten detecteren het eerste geval van de H5N1-vogelgriep bij een varken, wat aanleiding geeft tot bezorgdheid voor de mens

NASA zal in 2025 de ruimtewandelingen aan boord van het internationale ruimtestation hervatten na een lek in het ruimtepak